推薦LLM本地端開源大模型 2025年初

阿里巴巴的通譯千問Qwen2.5

7B模型適合6G以上模型全載入VRAM高速運作,新版模型更小更聰明能擊敗上個版本的上個級距對手,能好好理解System Prompt 以利角色化的設定,做為多元特色用法的創意發揮或是個人的專業成長,而14B模型需要12G 以上的顯卡,但會更聰明,8G以下也可以跑14B/Q2M版本。

但有政治潔癖的人不適合

Google本家的Gemma2

9B模型適合8G以上VRAM的顯卡運作,新版模型更小更聰明能擊敗上個版本的上個級距對手,能好好理解System Prompt 以利角色化的設定,中文及東方文化沒有Qwen2.5聰明,但由於是Google美國爸爸,在校園裡面給孩子使用比較沒有疑慮,用來設計學習角落協助中小學孩子在各領域的課業等應該是很棒的選擇,沒有8G以上獨顯的並不推薦用2B較不聰明的模型,可以改用TAIDE或Taiwan llama。

Llama3.2 Taiwan

8B參數量的Llama Taiwan在6G以上顯卡可順利運行, 基於Meta開源模型llama3.0訓練,加上繁體中文台灣文化知識以及法律、製造、醫療和電子等行業知識,因此在繁體中文上佔有優勢,但模型因為稍舊,表現可能不如上面兩個推薦模型。

原廠的llama3.2~3.3目前僅有小模型,沒有中模型,所以本地LLM 我並不推薦

TAIDE

7B參數量模型可在6G以上顯卡執行可商用,13B限學術使用,需要12G以上顯卡較為順暢,TAIDE模型基於Meta開源模型Llama 2進行開發,版本比較舊,表現可能沒有上述好。但以臺灣主體性文本為訓練素材,涵蓋政府及民間多元領域資料,如中央社、公共電視、各部會公開資料、法規資料庫等,確保模型回應符合臺灣文化與價值觀,被大量運用在臺語教學對話機器人、農業知識檢索系統「神農TAIDE」、多語言對話系統等,展現其多元應用潛力。

DeepSeek R1

微軟家的Phi-4

回答品質很不錯耶,分數也高於我目前建議的Qwen2.5 14B

也不會有政治不正確的問題,如果是科學和數學用途各位就換了吧

8G VRAM 可以用到 Phi-4/Q2M RTX-1080速度可到14 tok/s

很好,LLM的世界又更寬廣了

模型是否聰明?

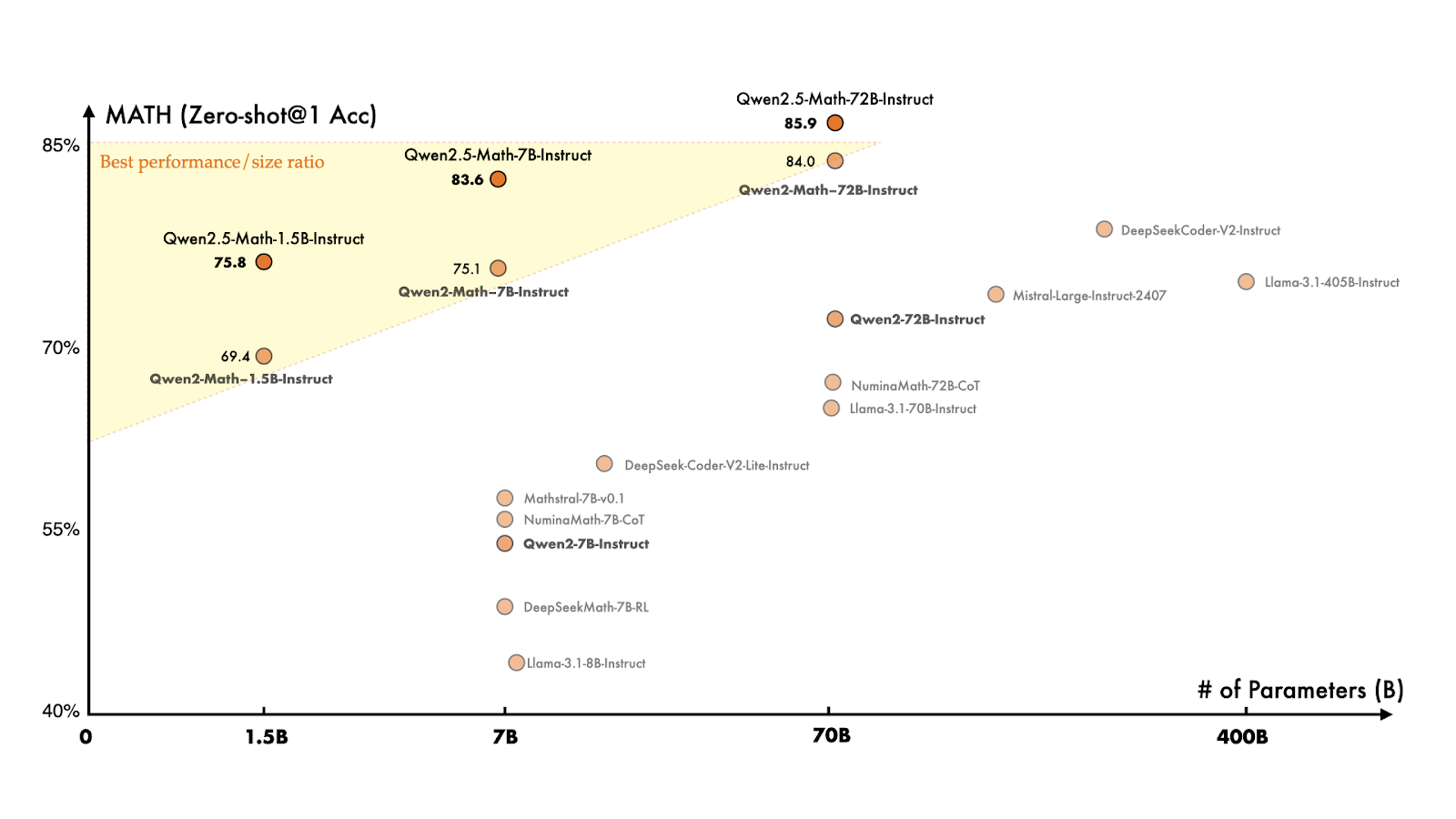

取自通譯千問網站,模型聰明程度比較表

模型的訓練參數資料中-中文的比例

- Llama模型:約90%的語料為英文,中文語料僅佔約0.13%,且包含繁體和簡體中文。

- 阿里研究院的報告指出,全球網站中,英文內容佔比約59.8%,而中文內容僅佔約1.3%。

- Llama模型:約90%的語料為英文,中文語料僅佔約0.13%,且包含繁體和簡體中文。

- 阿里研究院的報告指出,全球網站中,英文內容佔比約59.8%,而中文內容僅佔約1.3%。

待測試模型 (其實基底都是llama3或更舊版本,就不測了)

CKIP-Llama-2-7b

由中央研究院中文詞知識庫小組(CKIP Lab)開發,基於Llama 2進行繁體中文優化,擁有70億參數。該模型可應用於文案生成、問答系統、語言翻譯等多種任務。

Breeze-7B

由聯發科技開發,基於Mistral-7B模型進行微調,專為繁體中文設計,擁有70億參數。該模型可用於各種繁體中文自然語言處理任務。

Project TAME

全名為TAiwan Mixture of Experts,由台灣產學合作開發,旨在建立繁體中文專家模型,採用開源形式,促進各產業的合作與應用。

Chinese-LLaMA-Alpaca

該專案開源了中文LLaMA模型和指令精調的Alpaca大模型,擴充了中文詞表並使用了中文數據進行預訓練和微調,提升了模型在中文自然語言處理任務中的表現。

沒有留言:

張貼留言